Ситуация не из приятных: сканирование сайта поисковыми роботами проходит достаточно быстро, но процесс добавления страниц в индекс не оправдывает ожиданий. Одни страницы сайта не попадают в базу поисковых систем, а другие удаляются. В результате ресурс ранжируется по проиндексированным данным. Если в индекс попали целевые страницы, вам повезло чуть больше. Так или иначе на позиции сайта в выдаче проблемы с индексацией влияют отрицательно.

Мы подготовили чек-лист, который поможет быстро оценить видимость страниц индексе и их количество.

Корректное управление индексацией позволяет оптимизировать расход краулингового бюджета: роботы индексируют только важные для продвижения страницы.

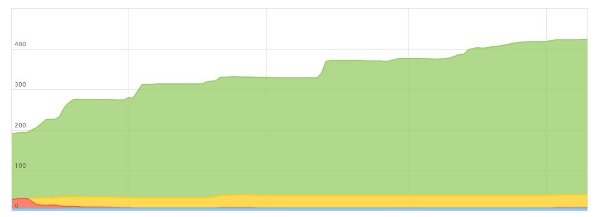

В Google Search Console проверяем «Статус индексирования» в разделе «Индекс». Проблемы с индексацией выглядят следующим образом:

Отметка «Проиндексировано всего» указывает число адресов, добавленных в индекс.

Просмотр удаленных страниц, прошедших индексацию успешно или с ошибкой доступен в отчете «Покрытие». Также можете проверить определенную страницу на попадание в индекс.

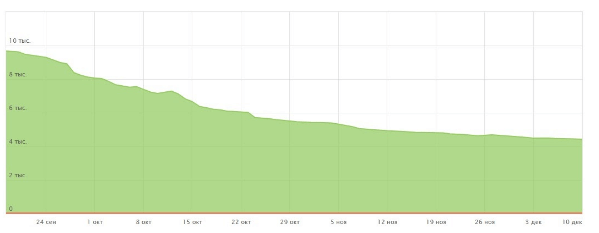

Проверка в Яндекс.Вебмастере осуществляется через путь «Индексирование сайта» — «Страницы в поиске». Далее при выборе «История» получим динамику количества страниц в поиске.

Пример сайта, не имеющего проблем с индексацией в Яндексе

Пример сайта с регулярно удаляемыми страницами.

Операторы поисковых систем используются для уточнения результатов поиска. Оператор «site:» выводит список проиндексированных страниц. Для применения параметра в поисковую строку Google или Яндекс введите «site:[url сайта]». Для получения точных данных в Google необходимо перейти на последнюю страницу поиска. Различия в полученных цифрах — показатель наличия проблем на сайте или его попадания под фильтр поисковых систем.

Оператор Cache проверяет частоту посещения сайта поисковым ботом. Настройте дополнительные инструменты поиска, чтобы просмотреть данные об индексации за час, день, неделю, месяц, год или все время.

Букмарклеты — скрипты, сохраняемые в закладках браузера. Принцип работы плагинов и букмарклетов одинаковый: открываете сайт для проверки и призываете на помощь закладку из браузера. В результате получаете необходимую информацию за один клик, ничего не прописывая и не настраивая.

Расширения: SEO-tools, RDS bar, SimilarWeb, MozBar.

Работа с плагином RDS bar

Специальные сервисы облегчают работу SEO-специалистов: позволяют не только проверить индексацию, но и выявить возможные проблемы. Среди таких сервисов: Netpeak Spider, SEO-reports, Rush Analytics. Кроме проиндексированных страниц дополнительно получаете код ответа, заголовки, метаописания, robots.txt и пр.

Возможные причины выпадения страниц из индекса и их решение:

Индексирование недавно появившегося сайта занимает много времени. Для ускорения процесса пройдите регистрацию в «Add url», разместите сайт в каталоге и добавьте ссылки с рейтинговых ресурсов, социальных сетей.

Ее основная функция: сообщать поисковым системам об изменениях на ресурсе и задавать частоту проверки. Такие карты помогают сайту индексироваться быстрее с более эффективной скоростью обхода.

Чтобы проверить, есть ли страница в файле sitemap, используйте инструмент проверки URL в Search Console.

В настройках чтения уберите галочку с пункта «Видимость для поисковых систем».

Чтобы найти все страницы с метатегом noindex на вашем сайте, выполните аудит сайта через Ahrefs: просмотрите предупреждения в отчете “Внутренние страницы”. Для борьбы с этой ошибкой необходимо избавиться от строки или заменить элементы на «index» и«follow».

Подробнее о работе с индексным файлом читайте здесь.

Заполните сайт качественным и собственным контентом, удалите мусорные страницы, чтобы избежать санкций от поисковиков.

Чтобы максимально повысить скорость индексации, обновляйте сайт не реже 3 раз в неделю. Например, размещайте новые публикации и обновляйте старый контент. Google будет чаще сканировать ваш сайт, а обновленные старые публикации сохранят актуальность для новых посетителей.

Собирайте информацию о соотношении проиндексированных страниц, динамике их индексации, отслеживайте тренды. Необходимо регулярно отслеживать индексирование сайта, чтобы своевременно решать проблемы и предотвращать отрицательные последствия, вносить изменения в стратегию продвижения.

В большинстве случаев я пользуюсь таким сервисом, как Netpeak Spider. После сканирования сайта можно определить не просто страницы, которые не индексируются, но и выявить причины непопадания их в индекс поисковых систем. Этих причин может быть много: отсутствие или некорректно заполненные заголовки, мета-теги (заголовки в выдаче), закрытие от индексации в служебном файле robots.txt, некорректно настроенный редирект и т.д. Наличие многофункциональных возможностей Netpeak Spider позволяет выгрузить различные типы страниц (например, индексируемые и неиндексируемые) с техническими ошибками в Excel, что в дальнейшем приводит к ускорению работы по исправлению неиндексируемых URL.